Zawartość

Główna różnica

Jednostka informacji bardzo różni się od innych rodzajów i dlatego należy ją rozumieć w bardziej skomplikowany sposób. Dwa omówione tutaj terminy, gigabit i gigabajt, można wyjaśnić zgodnie z definicjami Międzynarodowego Standardu Miar, zgodnie z którymi gigabit to jednostka informacji, która wynosi dziesięć podniesiona do potęgi dziewiątej, a dokładnie 2 podniesiona do potęgi trzydziestej bitów Podczas gdy Gigabyte jest terminem, który jest używany jako wielokrotność terminu bajt i może być zdefiniowany jako jednostka informacji, która jest również równa dziesięciu podniesionej do potęgi dziewięciu, lub dokładnie, 2 podniesionej do potęgi trzydziestu bajtów.

Wykres porównania

| Podstawa | Gigabit | Gigabajt |

| Definicja | Jednostka informacji, która wynosi dziesięć, jest podniesiona do potęgi dziewiątej. | Jednostka informacji, która wynosi dziesięć, jest podniesiona do potęgi dziewiątej. |

| Przestrzeń cyfrowa | Równa się 1 000 000 000 bitów | Równa się 1 000 000 000 bajtów |

| Przestrzeń binarna | 2 podniesione do potęgi 30 bitów, które są równe 1,073,741,824 bitów. | 2 podniesiony do potęgi 30 bajtów, która jest równa 1 073 741 824 bajtów. |

| Stosowanie | Rzadko spotykany | Wspólny |

| Jednostka | Gb lub Gbit | GB |

| Rozmiar | Mniejszy | 8 razy większy |

| Przykłady | Hosting dedykowanego serwera. | Miejsce na dysku, pamięć RAM i przepustowość |

Co to jest Gigabit?

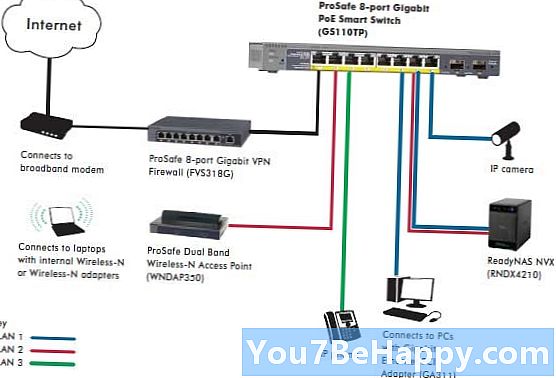

Jest to jednostka informacji, która wynosi dziesięć podniesionych do potęgi dziewięciu, a dokładnie 2 podniesionych do potęgi trzydziestu bitów. Jest uważany za większą formę terminu bit w wielu wielokrotnościach i jest używany do informacji cyfrowych, takich jak filmy, obrazy i inne typy. Jest również wykorzystywany w pamięci komputera lub innych urządzeniach, takich jak USB lub DVD. Głównym haczykiem w tym słowie jest Giga, która jest zdefiniowana jako jednostka, która zawsze wynosi 10 podniesiona do potęgi dziewiątej, która jest również znana jako jeden miliard, lub w postaci liczbowej jako 1 000 000 000. Jednostką centralną Gigabit jest Gb, ale w niektórych przypadkach jest również zapisany jako Gbit, co nie myli go z innymi podobnymi terminami, które używają z nim słowa Giga. Aby dać ludziom lepszy obraz tego, jak duży jest rozmiar, jeśli użyjemy jednego bajtu jako standardu, który jest równy 8 bitom, wówczas jeden gigabit będzie równy 125 megabajtom. Jest zbliżony do terminu gibibit, który wywodzi się z terminu binarny przedrostek gibi i ma ten sam rząd wielkości co gigabit i wynosi 2 podniesione do potęgi 30 bitów, które są równe 1 073 741 824 bitów. Aby wyjaśnić to nieco bardziej, termin ten jest również używany w sieci komputerowej, w której występuje Gigabit Ethernet, jest to termin opisujący kilka technologii, które transmitują z ramki Ethernet z prędkością 1 GB na sekundę, która staje się 1 miliard bitów na sekundę.

Co to jest Gigabyte?

Jest to termin, który jest używany jako wielokrotność terminu bajt i może być zdefiniowany jako jednostka informacji, która jest również równa dziesięciu podniesionej do potęgi dziewięciu, lub dokładnie, 2 podniesionej do potęgi trzydziestu bajtów. Centralnym symbolem używanym dla tego terminu jest GB. Termin ten jest bardzo znany w wielu dziedzinach życia, takich jak komputery, inżynieria, biznes i inne, w których dane muszą być przesyłane lub wykorzystywane. W technologii komputerowej jest również wykorzystywany w inny sposób, gdy ma ten sam rząd wielkości co gigabajt i jest równy 2 podniesiony do potęgi 30 bajtów, która jest równa 1 073 741 824 bajtów. Jest to termin większy niż termin Gigabit, ponieważ jeden bajt zawiera około 8 bitów. Najczęstszą definicją tego terminu jest to, że ma on wartość 100 podniesioną do potęgi 3 i jest używany do opisywania wielu rzeczy, takich jak nawet filmy. Zwykły film będzie miał wielkość od około 4 do 8 GB i dlatego wiele osób ma pojęcie, co to znaczy, ale nie zna dokładnie wyjaśnienia dotyczącego rozmiaru. Termin ten został przyjęty przez międzynarodową komisję elektrotechniczną w 1997 r. I został dodany jako właściwa jednostka przez IEEE w 2009 r. Jak wyjaśniono wcześniej, istnieją dwie definicje tego słowa, jedna jest w postaci dziesiętnej, w której jest równy 1 miliard bajtów i druga to definicja binarna, w której jest równa 2 podniesiona do potęgi 30 bajtów. Numer dwa jest używany ze względu na czynnik binarny.

Kluczowe różnice

- Zarówno terminy Gigabit, jak i Gigabyte są jednostkami miary cyfrowej przestrzeni dyskowej.

- Termin Gigabit ma jednostkę Gb lub Gbit, natomiast termin Gigabyte ma jednostki GB.

- Gigabajt jest większy niż gigabit pod względem dostępnej przestrzeni dyskowej, ponieważ jeden bajt zawiera 8 bitów.

- Najczęściej używanym terminem z tych dwóch jest Gigabyte, który jest używany do filmów i rozmiarów wideo, podczas gdy Gigabit jest rzadziej używany przez ludzi.

- Jeden gigabajt to 1 000 000 000 bajtów, a jeden gigabit to 1 000 000 000 bitów do celów cyfrowych.

- W przypadku zastosowań binarnych gigabajt można zdefiniować jako ilość równą 2 podniesionym do 30 bajtów potęgi, co jest równe 1 073 741 824 bajtów, podczas gdy gigabit jest równy 2 podniesionym do potęgi 30 bitów, które są równe 1 073 741 824 bitom.

- Gigabyte jest wykorzystywany głównie do przechowywania miejsca na dysku, pamięci RAM i przepustowości, podczas gdy gigabit służy głównie do hostingu dedykowanych serwerów.